Police prédictive: les députés européens contre l’IA et la surveillance de masse

La police prédictive constitue l’un des développements les plus attendu de l’IA. Son objectif principal est d’anticiper les crimes et les délits en utilisant notamment des données ouvertes et celles produites par les services de sécurité. Ces algorithmes prédictifs promettent de faire baisser la criminalité. Mais, ils marchandisent essentiellement la production de sécurité en stigmatisant davantage certaines catégories de la population. Outre le fait que ces logiciels reproduisent des biais racistes, ils représentent de manière plus générale un danger pour les droits fondamentaux. Cette approche productiviste est un échec. L’UE veut prohiber les usages répressifs de l’IA tels que la surveillance de masse.

Depuis quelques années, l’activité est devenue un véritable marché pour les éditeurs d’informatique décisionnelle (Palentir Law Enforcement, Bair Analytics, Information Builder) et pour les start-ups spécialisées dans la cartographie prédictive de géolocalisation du crime (Hunchlab et PredPol. Leur préoccupation première : quelle quantité de sécurité artificielle produire et comment pour faire baisser le taux de criminalité. Mais, peut-on vraiment contrôler la sécurité de toute une ville à partir d’une salle de commandement? Peut-on tracer des délinquants potentiels sur un mur d’écrans? Peut-on efficacement détecter des situations à risque ou des comportements suspects pour envoyer des patrouilles de police à temps? Telles sont les promesses de la surveillance de masse. Et pourtant, l’idée d’associer un modèle économique à la police prédictive est un échec et pour plusieurs raisons.

Prédire et anticiper

Les Américains sont les pionniers en matière de police prédictive, ce qui a donné lieu à un flot de séries télévisées. Depuis 2010, le département de police de Los Angeles (LAPD) teste PredPol, un dispositif développé par des chercheurs de l’université d’Etat de Californie. Les données que les algorithmes utilisent pour « prédire » portent sur un ensemble d’affaires traitées dans le passé par les forces de l’ordre, ce qui permet au logiciel d’établir des schémas prédictifs. Ainsi, si dans un quartier, les vols ont toujours lieu le mardi vers 20h00 dans une rue donnée, les autorités sauront qu’il y a de fortes chances pour que cela se reproduise mardi prochain au même endroit et une patrouille peut être envoyée à titre préventif. Portées par les promesses de l’intelligence artificielle, une soixantaine de services de polices ont ainsi rapidement adopté, dans plusieurs Etats, les techniques de police prédictive.

Les policiers estiment que rien ne prouve aujourd’hui que l’AI est efficace en matière de prévention des crimes et délits

Des a priori raciaux

Dix ans plus tard, le bilan est maigre. En mars 2019, un rapport de l’inspection générale de la police de Los Angeles pointe le manque de résultats. Les policiers estiment que rien ne prouve aujourd’hui que l’AI est efficace en matière de prévention des crimes et délits. Predpol ne fait pas mieux que les classiques cartes de point chauds. Il ressemble à l’algorithme d’Uber. Le logiciel n’a pas permis de réduire la criminalité. En outre, il fournit essentiellement des informations que les agents de policed connaissent déjà et le système souffre de biais techniques discriminants. Ces données reflètent des a priori raciaux et non pas la réalité du crime. En avril 2020, la police de Los Angeles a annoncé l’arrêt de l’utilisation de PredPol. Elle ne renouvelle pas son contrat avec l’éditeur du logiciel.

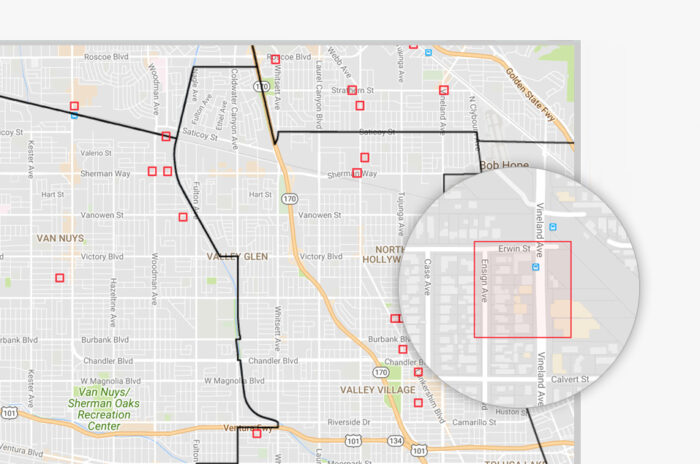

Cette carte de chaleur de Predpol indique aux forces de police les zones à surveiller © Predpol

Plus de transparence exigée

Soulignant les risques et le manque de fiabilité que présente l’emploi de l’IA à des fins policières et judiciaires sur base des expériences étrangères, dans une résolution adoptée par le parlement européen le 6 octobre, les députés demandent des garanties solides lorsque des outils d’intelligence artificielle sont utilisés par les services répressifs. Ils demande de réduire fortement ces pratiques et d’en interdire certaines, comme la surveillance de masse et la police prédictive, afin de garantir le droit au respect de la vie privée. L’IA peut également porter atteinte à des droits fondamentaux tels que la présomption d’innocence, en raison notamment de faux positifs, de l’opacité des résultats algorithmiques et de discrimination. Ces outils peuvent conduire à déformer la réalité et à réduire les chances de certaines catégories de personnes. Ils estiment aussi que les décisions finales doivent toujours être prises par un être humain et les personnes soumises à des systèmes alimentés par l’IA doivent disposer de voies de recours. Les algorithmes d’identification doivent être transparents, traçables et documentés.

Des droits fondamentaux irrévocables

La résolution demande part ailleurs de prohiber la reconnaissance automatisée des individus dans l’espace public, l’emploi de bases de données privées de reconnaissance faciale (à la Clearview), la police prédictive basée sur des données comportementales et les systèmes d’évaluation de la fiabilité des individus (social score à la chinoise).

Pour les parlementaires, le déploiement de l’IA à des fins policières et judiciaires ne se réduit pas à une question de faisabilité technique, mais relève du politique. Ils rappellent que le droit moderne repose sur la réponse à une infraction commise et non pas sur une surveillance préventive de tous les citoyens selon le principe qu’ils seraient potentiellement dangereux. « Nous envoyons un message clair: les droits fondamentaux sont irrévocables. Pour la toute première fois, nous appelons à un moratoire sur le déploiement des systèmes de reconnaissance faciale à des fins répressives, ces technologies ayant démontré leur inefficacité et souvent abouti à des résultats discriminants. Nous nous opposons clairement à la police prédictive fondée sur l’utilisation de l’IA ainsi que sur tout traitement des données biométriques conduisant à une surveillance de masse. C’est une énorme victoire pour tous les citoyens européens», a déclaré le rapporteur Petar Vitanov.

> Le texte de la résolution du Parlement européen du 6 octobre 2021 sur l’intelligence artificielle en droit pénal et son utilisation par les autorités policières et judiciaires dans les affaires pénales :

https://www.europarl.europa.eu/doceo/document/TA-9-2021-0405_FR.html